Qualitätsoptimierung im Shopfloor durch Big Data

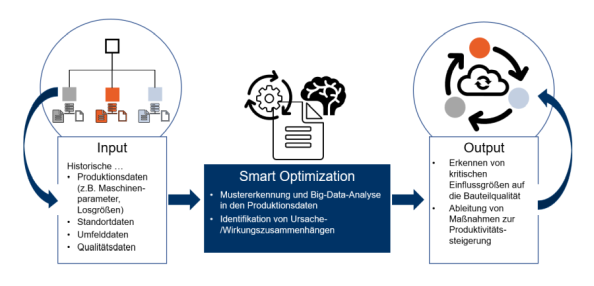

Die historischen Prozess- und Qualitätsdaten können genutzt werden, um Zusammenhänge zwischen Produktionsbedingungen und der resultierenden Bauteilqualität zu ermittlen. Der Schlüssel liegt hierzu in der identifikation von statistischen Zusammenhängen und Mustern in den Betriebsdaten durch Machine Learning.

„Der Zusammenhang zwischen historischen Produktionsdaten und den Qualitätsdaten kann von jedem Unternehmen genutzt werden, um aus Datenmustern zu lernen, wie die Qualität oder die Produktivität gesteigert werden können.“

Erprobte Algorithmen, wie etwa die Assoziationsanalyse, unterstützen Unternehmen dabei aus den eigenen Produktionsdaten zu lernen und Ursache-Wirkungszusammenhänge im Shopfloor aufzudecken. Die Ergebnisse versetzen die Unternehmen in die Lage, die eigenen Qualitätskosten zu senken und die Produktivität zu erhöhen. Dies wird ermöglicht durch das Erkennen von „starken Regeln“ in vielen Millionen Datenpunkten.

Fallbeispiel – Produktionsnetz eines Herstellers von Mechatronikbauteilen

Ein Unternehmen, das Mechatronik-Bauteile für die Automobilindustrie herstellt, betreibt 30 Werke. Die Produktpalette umfasst Baugruppen mit vielen Spritzgussteilen. Die Qualitäten der Produkte und die Stabilität des Outputs unterscheiden sich teilweise deutlich in einzelnen Werken, obwohl die Produkte ähnlich sind. Im Rahmen einer Qualitätsinitiative soll die Produktivität einzelner Werke durch eine höhere Bauteilqualität gesteigert werden.

Im Rahmen des Projektes stellt der Produktionsleiter fest, dass die 3 schlechtesten Werke alle für ein Spritzguss-Zukaufteil einen Low-Cost-Lieferanten nutzen. Der Produktionsleiter vermutet also, dass die Qualitätsprobleme des Endprodukts ihre Ursache im Low-Cost-Lieferanten haben. Er schlägt vor, auf den teureren Lieferanten, der von anderen Werken genutzt wird, zu wechseln, weil dann, so seine Überzeugung, die Qualitätsprobleme verschwinden würden.

„Der Data Science-Ansatz soll die Frage beantworten: Hat der Produktionsleiter Recht mit seiner Vermutung? Sollten alle Werke zukünftig nur noch Bauteile des Second Source Lieferanten beziehen? Wird dies die Qualitätsprobleme lösen?“

Die Entwicklung des Machine-Learning-Modells umfasst folgende Schritte:

- Auswahl, Sammlung und Systematisierung aller Produktionsdaten aller betrachteten Werke

- Entwicklung eines Data-Lakes für das Machine Learning Konzept

- Entwicklung der Datenschnittstellen, sodass neue Produktionsdaten automatisch in den Data Lake eingespeist werden

- Entwicklung, Test und Training des Machine Learning Modells

Nach den ersten Iterationen der Datenanalyse verdichteten sich folgende Erkenntnisse:

- Ein Wechsel vom Low-Cost-Lieferanten ist nicht anzuraten: Es gibt keinen echten statistischen Zusammenhang zwischen dem Spritzgussteil-Lieferanten und der Qualität des Endprodukts, die Beobachtungen des Produktionsleiters waren Zufälle.

- Die eigenen Spritzgusswerkzeuge scheinen ein Ursachenherd für Qualitätsprobleme zu sein: Es wurde ein starker statistischer Zusammenhang zwischen der Generation der eigenen Gusswerkzeuge und der Qualität des Endprodukts festgestellt. Im Workshop wurden besonders auffällige Werkzeugsätze überprüft und es zeigte sich, dass die Werkzeugsätze, welche statistisch mit einer hohen Endqualität in Verbindung gebracht werden konnten, hinsichtlich eines Wärmeabtrags optimiert wurden, was zu schnelleren Abkühlkurven und damit einer höheren Bauteilqualität führte.

- Die Temperatur hat einen Einfluss auf die Endteilqualität: Der Algorithmus erkannte in allen Werken einen starken Zusammenhang zwischendem Produktionsmonat, der Region und der Qualität des Endprodukts. Die Variable, die das erklären kann, ist die Temperatur. Im gemeinsamen Workshop mit den Mitarbeitern wurde die Ursache identifiziert, denn nur die Klebeverbindung unterliegt einem nennenswerten Temperatureinfluss.

Neben der Entwicklung des Machine Learning Modells galt es auch, das Data Science Konzept nachhaltig in der Organisation zu verankern:

- Entwicklung einer Datenstrategie

- Schulung des Prozessmodells und Entwicklung eines dauerhaften Qualitäts-Controlling-Zirkels um den Machine Learning Ansatz weiterhin zur Produktivitätssteigerung in allen Werken zu nutzen

- Rollout des Konzepts auf alle Werke

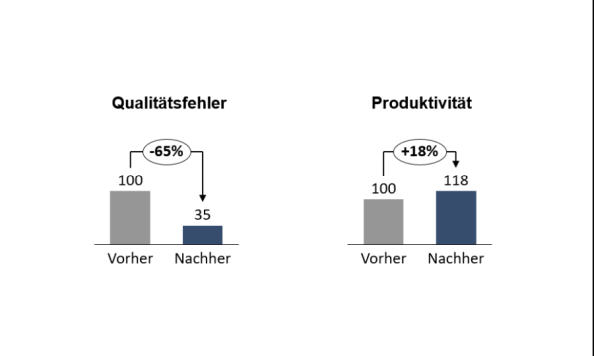

Realisierte Potenziale nach Projektende

Der implementierte Machine Learning Algorithmus führte dazu, dass die relevanten Ursachen-/Wirkungskomplexe hinsichtlich der Produktqualität aufgedeckt wurden. Durch den Maßnahmenkatalog konnten Qualitätsfehler um 65% reduziert und die Produktivität um 18% gesteigert werden. Auch wurden neue, bisher unbekannte Qualitätshebel aufgedeckt. Auf Basis der Ergebnisse konnte ein kontiniuerlicher Verbesserungsprozess in allen Werken angestoßen werden. Zudem wurde ein werksübergreifendes Team ins Leben gerufen, welches das Data Science Tool nutzt, um weitere Verbesserungen im Produktionsnetz anzustoßen.